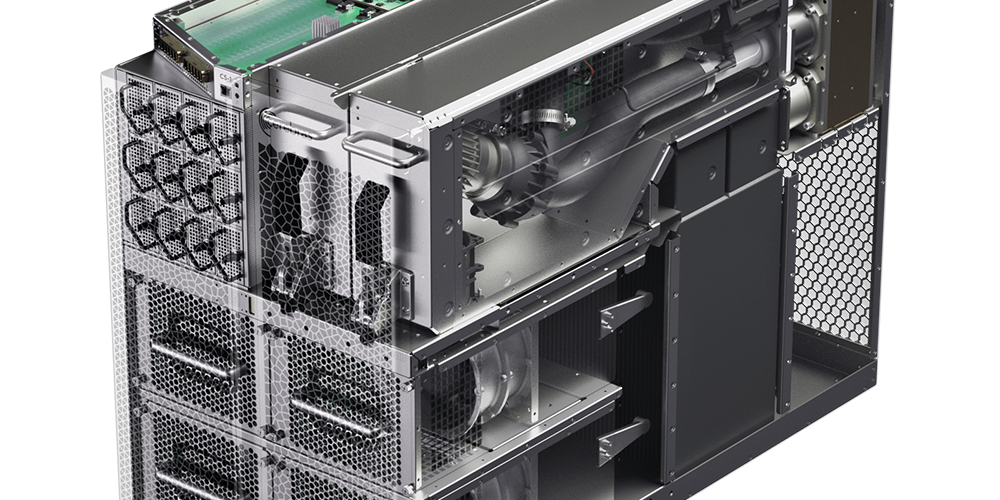

硅谷芯片制造初创公司 Cerebras Systems 于当地时间 8 月 24 日宣布,一款小型冰箱大小的深度学习系统 Cerebras CS-2 发布,该系统配备了使用单个硅片的巨型芯片。

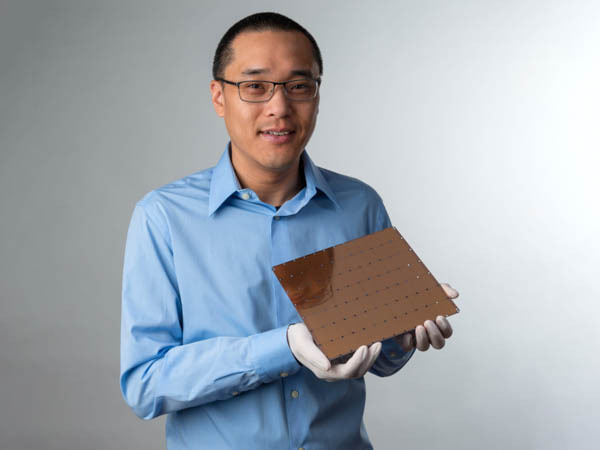

Celebras Systems成立于2016年,是一家半导体制造商,是一家总部位于硅谷的人工智能系统开发公司。 2019 年,它发布了晶圆级引擎 (WSE),这是一款尺寸为 20 × 22 厘米的芯片。此外,搭载 WSE 的深度学习系统 Cellebras CS-1 据说在模拟中产生了超越物理定律的验证结果。

Celebras CS-2是Celebras Systems此次发布的搭载2.6万亿晶体管的WSE2。根据公告,将计算单元和参数与存储解耦的 Cerebras Weight Streaming 简化了工作负载分布模型,并允许 CS-2 从 1 个单元扩展到 192 个单元,最高可达 2.4PB Cerebras MemoryX,一种可以支持高- 具有 120 万亿个参数的性能内存和模型,以及可连接 1.63 亿个 AI 优化内核的 Celebras Swarm,最多可跨 192 个 CS-2 据说包括四种新技术:Cerebras SwarmX (X)、Selectable Sparsity,其中权重可以被动态选择。

Celebras CS-2 引起注意的事实是,即使添加了芯片,电源效率也在下降。目前AI中使用的神经网络不能用一个芯片处理,所以一般分布在多个芯片上。但是,芯片越多,功率效率越低,因此需要大量的功率来提高深度学习系统的整体处理能力。

另一方面,即使芯片数量增加,Celebras CS-2 的电源效率也不会改变。因此,Cellebras CS02 可以在保持功率效率的情况下扩展到 192 个,将 1.63 亿个内核连接到一个,并训练一个比人脑具有 120 万亿个参数的神经网络。

根据 Cellebras Systems 的说法,像 GPT-3 这样的大规模网络让迄今为止难以想象的事情发生,自然语言处理 NLP 的情况正在发生变化。他强调,已经实现了120万亿个参数的神经网络。相关信息可以在这里找到。

Add comment