在公司会议在线召开的GTC2020期间,NVIDIA首席执行官黄仁勋(Jensen Huang)在NVIDIA A100的发布会上发表了主题演讲。NVIDIAA100是具有下一代Ampere架构的数据中心GPU。

他说云计算和AI趋势正在推动数据中心设计的结构变化。采用Ampere微体系结构的NVIDIA A100是一种端到端的机器学习加速器,它将AI的性能提高到以前型号的20倍, Tesla V100,从数据分析到推理。强调。

此外,与A100 GPU一起实现的第三代NVLink互连增加了每个GPU和交换机的链接数量,因此第三代NVLink显着扩展了GPU之间的通信带宽,实现了50 Gbps的信号传输以及错误检测和恢复。功能。据说已经改善了。

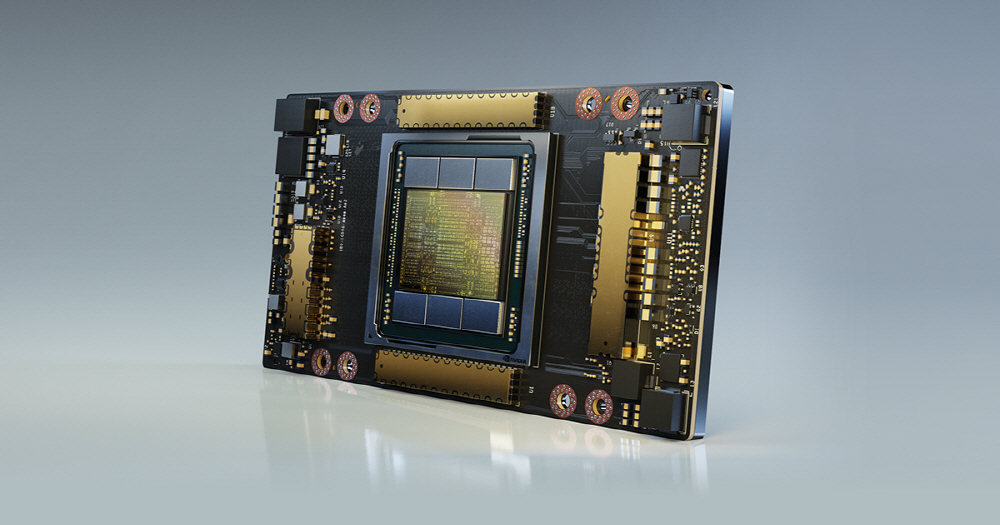

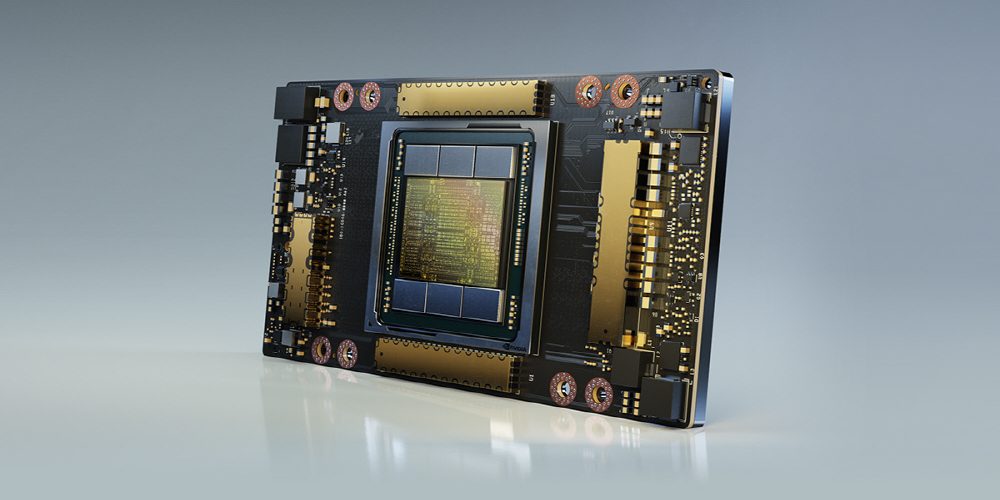

如果您查看NVIDIA A100的规格,它使用TSMC 7nm制造工艺,管芯尺寸为826mm 2 ,晶体管数量为542亿个,几乎是现有Tesla V100的两倍。 GPU内存为40GB,内存带宽为1.555TB / sec,散热设计功率高达400W。

A100 GPU的最大特点是它包括多实例GPU MIG(多实例GPU)功能,即GPU分区功能。它划分GPU资源,并允许对其他实例进行并行处理。一块芯片最多可以处理7个实例。

它还发布了Ampere架构和A100 GPU,以及NVIDIA的并行计算平台CUDA11。CUDA11加速了各种工作负载,包括高性能计算和基因分析,5G通信电影渲染以及深度学习数据分析。 Nvidia还是第三代集成AI系统,在GPU上具有8个A100,在CPU上具有2个AMD Epic Roma,用于存储的15TB SSD,在交换芯片上具有6个NVswitch,在网络接口上具有Melanox。它还发布了DGX A100,该设备配备了九个ConnectX-6 200Gbps(ConnectX -6 200Gbps)。根据Nvidia的数据,DGX A100将在一个单元中显示5 petaflops的计算能力,价格为199,000美元。

根据Nvidia的说法,A100 GPU已被多家公司和研究实验室使用。微软使用基于Ampere架构的GPU训练了全球最大的语言模型Turing NLG,具有170亿个参数。同时,视频中Jensen Huang发表主题演讲的位置是他在加利福尼亚的家中的厨房。相关信息可以在这里找到。

Add comment